搜索到

13

篇与

MySQL

的结果

-

Mysql数据表生成文档表结构,导出并生成word文档的方法 因为项目需要编写库表结构word文档,需要交付验收,下面给大家介绍一种我用的方式步骤一:使用sql生成表结构数据SELECT ORDINAL_POSITION 序号, COLUMN_NAME 列名, COLUMN_TYPE 数据类型, -- COLUMN_DEFAULT 默认值, (CASE IS_NULLABLE WHEN 'NO' THEN '否' WHEN 'YES' THEN '是' ELSE '' END) 允许为空, COLUMN_KEY 主键, COLUMN_COMMENT 注释 FROM information_schema.`COLUMNS` WHERE TABLE_SCHEMA='dbname' -- 库名 AND table_name='table_demo' -- 表明步骤二:使用Navicat Premium工具导出Excle我们将查询成功的数据导出Excel,并将内容复制到doc中即可有其它更好方式的可以推荐下哦,虽然这个方法步骤有点多,但是总比一个个复制要好些,写代码动手能力比较强的伙伴,可以考虑使用上面的sql查询代码来生成表格,然后用代码生成word文档,navicat premium破解版获取点击: navicat premium破解版下载

Mysql数据表生成文档表结构,导出并生成word文档的方法 因为项目需要编写库表结构word文档,需要交付验收,下面给大家介绍一种我用的方式步骤一:使用sql生成表结构数据SELECT ORDINAL_POSITION 序号, COLUMN_NAME 列名, COLUMN_TYPE 数据类型, -- COLUMN_DEFAULT 默认值, (CASE IS_NULLABLE WHEN 'NO' THEN '否' WHEN 'YES' THEN '是' ELSE '' END) 允许为空, COLUMN_KEY 主键, COLUMN_COMMENT 注释 FROM information_schema.`COLUMNS` WHERE TABLE_SCHEMA='dbname' -- 库名 AND table_name='table_demo' -- 表明步骤二:使用Navicat Premium工具导出Excle我们将查询成功的数据导出Excel,并将内容复制到doc中即可有其它更好方式的可以推荐下哦,虽然这个方法步骤有点多,但是总比一个个复制要好些,写代码动手能力比较强的伙伴,可以考虑使用上面的sql查询代码来生成表格,然后用代码生成word文档,navicat premium破解版获取点击: navicat premium破解版下载 -

linux 定时任务备份至七牛 场景生产数据定时备份的意义大家应该都是知道的,很多人备份只是备份到了本地,但是也会存在一定的隐患,比如客户一直不用系统,我们也不去注意,哪天服务器到期了过了几个月客户突然要用方向数据没了。。。使用到的工具主要看大家的服务器的安装情况,如果是安装了宝塔面板这种,有定时任务工具直接使用,而且也有免费的七牛云插件,设置起来超级简单,如果安装宝塔的不懂设置可以评论区留言,实在是太简单了本文就不讲了,说实话是会点鼠标就可以弄了基于linux系统内备份大概的意思就是你的mysql是自己用命令安装的。七牛平台shell脚本linux定时任务需要七牛云账号,用户需要自己创建,或者其它用其它云盘原理都是一样的(一)下载qshell工具并安装设置1. 工具下载说明文档与下载地址: 七牛工具下载 工具是七牛官方提供的,下载工具后传到服务器,主要看自己服务器的架构,我的服务是linux x86的,根据自己服务器去下载,把文件上传至服务目录/home/backup/shell 目录。并赋予权限chomd +x qshell2. 登录设置七牛云账号注意需要在工具目录下执行,如果需要任何目录执行需要添加环境变量可查看官方文档说明,更多说明以官方最新文档为准# 参数说明可自己根据情况修改 #ak :官方获取 #sk: 官方平台获取 #name : 任意用户名,不是七牛的账户,比如 db-test qshell account <ak> <sk> <name> #完成命令参考(二) shell编辑脚本在目录/home/backup/shell 下新建脚本backup.sh#!/bin/sh # mysql data backup script # # use mysqldump --help,get more detail. # 需要设置环境变量,crond中默认读取不到我们的一些环境 PATH=$PATH:/home/backup/shell export PATH dbname=<dbname> #备份文件目录 bakDir=/home/backup/sql logFile=/home/backup/backup.log month=` date +%Y%m ` # 七牛的备份目录,当前按数据库为一级目录,月份为2级目录如:dbname/202004/****.gz.sql qiniuPath=typecho_joe_theme/$month # 七牛空间名 qiniuBucket=<bucketName> datetime=`date +%Y%m%d%H%M%S` keepDay=7 echo "-------------------------------------------" >> $logFile echo $(date +"%y-%m-%d %H:%M:%S") >> $logFile echo "--------------------------" >> $logFile cd $bakDir bakFile=$dbname.$datetime.sql.gz # yum,apt-get,源码编译安装释放 mysqldump -u$user -p$password $dbname | gzip > $bakFile #docker安装执行方式,需要修改<dbname>为自己的数据库 #docker exec mysql5.6 sh -c 'exec mysqldump <dbname> -uroot -p"$MYSQL_ROOT_PASSWORD"' | gzip > $bakDir/$bakFile echo "数据库 [$dbname] 备份完成" >> $logFile echo "$bakDir/$bakFile" >> $logFile echo "开始上传备份文件至七牛云存储" >> $logFile #七牛上传命令,分片上传适用大文件,当前使用低频储存,具体命令可以查看文档 qshell rput $qiniuBucket $qiniuPath/$bakFile $bakDir/$bakFile --storage 1 | sed -r "s/\x1B\[([0-9]{1,2}(;[0-9]{1,2})?)?[m|K]//g" >> $logFile 2>&1 echo "删除${keepDay}天前的备份文件" >> $logFile find $bakDir -ctime +$keepDay >> $logFile find $bakDir -ctime +$keepDay -exec rm -rf {} \; echo " " >> $logFile echo " " >> $logFile 参考文献:qshell命令说明rput 操作说明(二) 添加定时任务需要使用到cron命令,本文不展开讲这个,需要了解的可以参考以下文献文献一: crontab配置方法文献二: Linux系统crontab定时任务的配置概要与常见问题文献三: crontab 与 环境变量下面直说具体操作,执行器需要先检查crond的状态service crond status,如果是在运行中就没什么问题编辑定时任务#修改当前用户定时任务 crontab -e 添加任务脚本,操作和vi是一样的# 每天凌晨3点执行脚本, 0 3 * * * /home/backup/backup.sh # 如果是测试可以用以下的脚本,意思是没2分钟执行一次,看看有没有成本 */2 * * * * /home/backup/backup.sh查看定时任务#查看当前任务情况 crondtab -l(三) 完成设置完成以后最好要检查下是否成功,建议先设置按分钟执行备份看看,如果中间有什么问题要多百度,一般都可以搜得到

linux 定时任务备份至七牛 场景生产数据定时备份的意义大家应该都是知道的,很多人备份只是备份到了本地,但是也会存在一定的隐患,比如客户一直不用系统,我们也不去注意,哪天服务器到期了过了几个月客户突然要用方向数据没了。。。使用到的工具主要看大家的服务器的安装情况,如果是安装了宝塔面板这种,有定时任务工具直接使用,而且也有免费的七牛云插件,设置起来超级简单,如果安装宝塔的不懂设置可以评论区留言,实在是太简单了本文就不讲了,说实话是会点鼠标就可以弄了基于linux系统内备份大概的意思就是你的mysql是自己用命令安装的。七牛平台shell脚本linux定时任务需要七牛云账号,用户需要自己创建,或者其它用其它云盘原理都是一样的(一)下载qshell工具并安装设置1. 工具下载说明文档与下载地址: 七牛工具下载 工具是七牛官方提供的,下载工具后传到服务器,主要看自己服务器的架构,我的服务是linux x86的,根据自己服务器去下载,把文件上传至服务目录/home/backup/shell 目录。并赋予权限chomd +x qshell2. 登录设置七牛云账号注意需要在工具目录下执行,如果需要任何目录执行需要添加环境变量可查看官方文档说明,更多说明以官方最新文档为准# 参数说明可自己根据情况修改 #ak :官方获取 #sk: 官方平台获取 #name : 任意用户名,不是七牛的账户,比如 db-test qshell account <ak> <sk> <name> #完成命令参考(二) shell编辑脚本在目录/home/backup/shell 下新建脚本backup.sh#!/bin/sh # mysql data backup script # # use mysqldump --help,get more detail. # 需要设置环境变量,crond中默认读取不到我们的一些环境 PATH=$PATH:/home/backup/shell export PATH dbname=<dbname> #备份文件目录 bakDir=/home/backup/sql logFile=/home/backup/backup.log month=` date +%Y%m ` # 七牛的备份目录,当前按数据库为一级目录,月份为2级目录如:dbname/202004/****.gz.sql qiniuPath=typecho_joe_theme/$month # 七牛空间名 qiniuBucket=<bucketName> datetime=`date +%Y%m%d%H%M%S` keepDay=7 echo "-------------------------------------------" >> $logFile echo $(date +"%y-%m-%d %H:%M:%S") >> $logFile echo "--------------------------" >> $logFile cd $bakDir bakFile=$dbname.$datetime.sql.gz # yum,apt-get,源码编译安装释放 mysqldump -u$user -p$password $dbname | gzip > $bakFile #docker安装执行方式,需要修改<dbname>为自己的数据库 #docker exec mysql5.6 sh -c 'exec mysqldump <dbname> -uroot -p"$MYSQL_ROOT_PASSWORD"' | gzip > $bakDir/$bakFile echo "数据库 [$dbname] 备份完成" >> $logFile echo "$bakDir/$bakFile" >> $logFile echo "开始上传备份文件至七牛云存储" >> $logFile #七牛上传命令,分片上传适用大文件,当前使用低频储存,具体命令可以查看文档 qshell rput $qiniuBucket $qiniuPath/$bakFile $bakDir/$bakFile --storage 1 | sed -r "s/\x1B\[([0-9]{1,2}(;[0-9]{1,2})?)?[m|K]//g" >> $logFile 2>&1 echo "删除${keepDay}天前的备份文件" >> $logFile find $bakDir -ctime +$keepDay >> $logFile find $bakDir -ctime +$keepDay -exec rm -rf {} \; echo " " >> $logFile echo " " >> $logFile 参考文献:qshell命令说明rput 操作说明(二) 添加定时任务需要使用到cron命令,本文不展开讲这个,需要了解的可以参考以下文献文献一: crontab配置方法文献二: Linux系统crontab定时任务的配置概要与常见问题文献三: crontab 与 环境变量下面直说具体操作,执行器需要先检查crond的状态service crond status,如果是在运行中就没什么问题编辑定时任务#修改当前用户定时任务 crontab -e 添加任务脚本,操作和vi是一样的# 每天凌晨3点执行脚本, 0 3 * * * /home/backup/backup.sh # 如果是测试可以用以下的脚本,意思是没2分钟执行一次,看看有没有成本 */2 * * * * /home/backup/backup.sh查看定时任务#查看当前任务情况 crondtab -l(三) 完成设置完成以后最好要检查下是否成功,建议先设置按分钟执行备份看看,如果中间有什么问题要多百度,一般都可以搜得到 -

【MySql】Specified key was too long; max key length is 767 bytes的解决方案 问题背景由于业务需要,需要做数据库迁移,迁移由5.7版本得mysql到现有的mysql5.6版本,主要是因为更innodb_large_prefix 参数有关由于MySQL的InnoDB引擎表索引字段长度的限制为767字节,因此对于多字节字符集的大字段或者多字段组合,创建索引时会出现该问题。在5.6中innodb_large_prefix 默认关闭,在5.7中默认开启。在5.6中默认为 offSpecified key was too long; max key length is 767 bytes原来是主键的长度太长,最大长度仅支持767字节,注意,这里的是字节。那么,我定义一个主键是varchar(500)的字段,不管我使用utf8编码,那么500字符长度将占用5003的字节长度(utf8最多支持3个字节长度);或是我使用utf8mb4编码,那么500字符长度将占用5004的字节长度(utf8mb4最多支持4个字节长度),都大大超过了767字节。如何去解决呢?先检查一下是不是数据库被限制了索引的大小,查询innodb_large_prefix这个字段,这个字段限制了索引前缀的大小。关闭此限制后,索引前缀的大小将可以达到3072字节。方法1:修改全局变量修改全局变量 ,当mysql重启后将失效,建议直接修改配置文件SHOW variables like 'innodb_large_prefix';如果查询的值是OFF的话 执行下面命令SET GLOBAL INNODB_LARGE_PREFIX = ON;另外,innodb_large_prefix这个属性在5.6上是默认关闭的,而在5.7上是默认开启的。执行完了 之后 还得查看当前的innodb_file_format引擎格式类型是不是BARRACUDA执行SHOW variables like 'innodb_file_format';如果不是的话则需要修改SET GLOBAL innodb_file_format = BARRACUDA;方法二:修改配置[mysqld] innodb_large_prefix = on innodb_file_format = BARRACUDA最后,创建表的时候,还需要指定表的 row format 格式为 Dynamic 或者 Compressed,如下示例:CREATE TABLE test( name varchar(500) CHARACTER SET utf8 COLLATE utf8_bin, PRIMARY KEY (`name `) USING BTREE ) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_bin ROW_FORMAT = Dynamic;版权声明:本文为CSDN博主「SunAlwaysOnline」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。参考原文链接:https://blog.csdn.net/qq_33591903/article/details/103927547

【MySql】Specified key was too long; max key length is 767 bytes的解决方案 问题背景由于业务需要,需要做数据库迁移,迁移由5.7版本得mysql到现有的mysql5.6版本,主要是因为更innodb_large_prefix 参数有关由于MySQL的InnoDB引擎表索引字段长度的限制为767字节,因此对于多字节字符集的大字段或者多字段组合,创建索引时会出现该问题。在5.6中innodb_large_prefix 默认关闭,在5.7中默认开启。在5.6中默认为 offSpecified key was too long; max key length is 767 bytes原来是主键的长度太长,最大长度仅支持767字节,注意,这里的是字节。那么,我定义一个主键是varchar(500)的字段,不管我使用utf8编码,那么500字符长度将占用5003的字节长度(utf8最多支持3个字节长度);或是我使用utf8mb4编码,那么500字符长度将占用5004的字节长度(utf8mb4最多支持4个字节长度),都大大超过了767字节。如何去解决呢?先检查一下是不是数据库被限制了索引的大小,查询innodb_large_prefix这个字段,这个字段限制了索引前缀的大小。关闭此限制后,索引前缀的大小将可以达到3072字节。方法1:修改全局变量修改全局变量 ,当mysql重启后将失效,建议直接修改配置文件SHOW variables like 'innodb_large_prefix';如果查询的值是OFF的话 执行下面命令SET GLOBAL INNODB_LARGE_PREFIX = ON;另外,innodb_large_prefix这个属性在5.6上是默认关闭的,而在5.7上是默认开启的。执行完了 之后 还得查看当前的innodb_file_format引擎格式类型是不是BARRACUDA执行SHOW variables like 'innodb_file_format';如果不是的话则需要修改SET GLOBAL innodb_file_format = BARRACUDA;方法二:修改配置[mysqld] innodb_large_prefix = on innodb_file_format = BARRACUDA最后,创建表的时候,还需要指定表的 row format 格式为 Dynamic 或者 Compressed,如下示例:CREATE TABLE test( name varchar(500) CHARACTER SET utf8 COLLATE utf8_bin, PRIMARY KEY (`name `) USING BTREE ) ENGINE = InnoDB CHARACTER SET = utf8 COLLATE = utf8_bin ROW_FORMAT = Dynamic;版权声明:本文为CSDN博主「SunAlwaysOnline」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。参考原文链接:https://blog.csdn.net/qq_33591903/article/details/103927547 -

Mysql数据库误删/错删数据恢复-binlog日志使用 一、binlog 基本认识MySQL的二进制日志可以说是MySQL最重要的日志了,它记录了所有的DDL和DML(除了数据查询语句)语句,以事件形式记录,还包含语句所执行的消耗的时间,MySQL的二进制日志是事务安全型的。一般来说开启二进制日志大概会有1%的性能损耗(参见MySQL官方中文手册 5.1.24版)。二进制有两个最重要的使用场景:MySQL Replication在Master端开启binlog,Mster把它的二进制日志传递给slaves来达到master-slave数据一致的目的,也就是大家比较常听到主从复制,和读写分离的应用场景数据恢复,通过使用mysqlbinlog工具来使恢复数据,也是大家说的数据恢复,用于数据误删找回的场景使用。二进制日志包括两类文件:二进制日志索引文件(文件名后缀为.index)用于记录所有的二进制文件,二进制日志文件(文件名后缀为.00000*)记录数据库所有的DDL和DML(除了数据查询语句)语句事件。二、开启binlog日志编辑打开mysql配置文件vi /usr/local/mysql/etc/my.cnf在[mysqld] 区块下,设置/添加 log-bin=mysql-bin 确认是打开状态(值 mysql-bin 是日志的基本名或前缀名); #开启log日志 log-bin = mysql-bin #默认路径可修改 log_bin = /var/lib/mysql/mysql-bin.log #日志过期时间,设置为0则永不过期,默认设置不过期 expire_logs_days = 7 #模式 binlog_format = ROW #超过max_binlog_size或超过6小时会切换到下一序号文件 max_binlog_size = 100M #二进制日志缓冲大小,通过show status like 'binlog_%';查看调整写入磁盘的次数,写入磁盘为0最好 binlog_cache_size = 16M max_binlog_cache_size = 256M #改参数默认是打开的,在数据库启动后立即启动自动relay log恢复,在恢复过程中,创建一个新的relay log文件,将sql线程的位置初始化到新的relay log,并将i/o线程初始化到sql线程位置。 relay_log_recovery = 1 关于MYSQL中binlog_format参数说明重启mysqld服务使配置生效三、登录mysql服务器,通过mysql的变量配置表,查看二进制日志是否已开启登录服务器mysql -uroot -p123456 mysql> show variables like 'log_%'; +----------------------------------------+---------------------------------------+ | Variable_name | Value | +----------------------------------------+---------------------------------------+ | log_bin | ON | ------> ON表示已经开启binlog日志 | log_bin_basename | /usr/local/mysql/data/mysql-bin | | log_bin_index | /usr/local/mysql/data/mysql-bin.index | | log_bin_trust_function_creators | OFF | | log_bin_use_v1_row_events | OFF | | log_error | /usr/local/mysql/data/martin.err | | log_output | FILE | | log_queries_not_using_indexes | OFF | | log_slave_updates | OFF | | log_slow_admin_statements | OFF | | log_slow_slave_statements | OFF | | log_throttle_queries_not_using_indexes | 0 | | log_warnings | 1 | +----------------------------------------+---------------------------------------+四、常用binlog日志操作命令1.查看所有binlog日志列表 mysql> show master logs;2.查看master状态,即最后(最新)一个binlog日志的编号名称,及其最后一个操作事件pos结束点(Position)值 mysql> show master status;3.刷新log日志,自此刻开始产生一个新编号的binlog日志文件 mysql> flush logs; 注: 每当mysqld服务重启时,会自动执行此命令,刷新binlog日志;在mysqldump备份数据时加 -F 选项也会刷新binlog日志;4.重置(清空)所有binlog日志,请勿在正式环境操作mysql> reset master;五、查看某个binlog日志内容,常用有两种方式:1.使用mysqlbinlog自带查看命令法:注: binlog是二进制文件,普通文件查看器cat more vi等都无法打开,必须使用自带的 mysqlbinlog 命令查看binlog日志与数据库文件在同目录中(我的环境配置安装是选择在/usr/local/mysql/data中)使用mysqlbinlog命令时如果报错,就加上 --no-defaults选项mysqlbinlog /usr/local/mysql/data/mysql-bin.000013下面截取一个片段分析: # at 552 #131128 17:50:46 server id 1 end_log_pos 665 Query thread_id=11 exec_time=0 error_code=0 ---->执行时间:17:50:46;pos点:665 SET TIMESTAMP=1385632246/*!*/; update zyyshop.stu set name='李四' where id=4 ---->执行的SQL /*!*/; # at 665 #131128 17:50:46 server id 1 end_log_pos 692 Xid = 1454 ---->执行时间:17:50:46;pos点:692 注:server id 1 数据库主机的服务号;end_log_pos 665 pos点thread_id=11 线程号2.上面这种办法读取出binlog日志的全文内容较多,不容易分辨查看pos点信息,这里介绍一种更为方便的查询命令: show binlog events [IN 'log_name'] [FROM pos] [LIMIT [offset,] row_count]; 选项解析:IN 'log_name' 指定要查询的binlog文件名(不指定就是第一个binlog文件)FROM pos 指定从哪个pos起始点开始查起(不指定就是从整个文件首个pos点开始算)LIMIT [offset,] 偏移量(不指定就是0)row_count 查询总条数(不指定就是所有行) 截取部分查询结果: *************************** 20. row *************************** Log_name: mysql-bin.000021 ----------------------------------------------> 查询的binlog日志文件名 Pos: 11197 ----------------------------------------------------------> pos起始点: Event_type: Query ----------------------------------------------------------> 事件类型:Query Server_id: 1 --------------------------------------------------------------> 标识是由哪台服务器执行的 End_log_pos: 11308 ----------------------------------------------------------> pos结束点:11308(即:下行的pos起始点) Info: use `zyyshop`; INSERT INTO `team2` VALUES (0,345,'asdf8er5') ---> 执行的sql语句 *************************** 21. row *************************** Log_name: mysql-bin.000021 Pos: 11308 ----------------------------------------------------------> pos起始点:11308(即:上行的pos结束点) Event_type: Query Server_id: 1 End_log_pos: 11417 Info: use `zyyshop`; /*!40000 ALTER TABLE `team2` ENABLE KEYS */ *************************** 22. row *************************** Log_name: mysql-bin.000021 Pos: 11417 Event_type: Query Server_id: 1 End_log_pos: 11510 Info: use `zyyshop`; DROP TABLE IF EXISTS `type`这条语句可以将指定的binlog日志文件,分成有效事件行的方式返回,并可使用limit指定pos点的起始偏移,查询条数;A.查询第一个(最早)的binlog日志: mysql> show binlog events\G; B.指定查询 mysql-bin.000021 这个文件:mysql> show binlog events in 'mysql-bin.000021';C.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起:mysql> show binlog events in 'mysql-bin.000021' from 8224;D.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起,查询10条mysql> show binlog events in 'mysql-bin.000021' from 8224 limit 10;E.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起,偏移2行,查询10条 mysql> show binlog events in 'mysql-bin.000021' from 8224 limit 2,10;六、binlog日志恢复实验我们来模拟数据恢复的场景 ,zyyshop是数据库1.(时间线1)假设现在是凌晨4:00,我的计划任务开始执行一次完整的数据库备份:将zyyshop数据库备份到 /root/BAK.zyyshop.sql 文件中:mysqldump -uroot -p123456 -lF --log-error=/root/myDump.err -B zyyshop > /root/BAK.zyyshop.sql大约过了若干分钟,备份完成了,我不用担心数据丢失了,因为我们有备份了由于我使用了-F选项,当备份工作刚开始时系统会刷新log日志,产生新的binlog日志来记录备份之后的数据库“增删改”操作,查看一下: mysql> show master status; +------------------+----------+--------------+------------------+ | File | Position | Binlog_Do_DB | Binlog_Ignore_DB | +------------------+----------+--------------+------------------+ | mysql-bin.000023 | 120 | | | +------------------+----------+--------------+------------------+也就是说, mysql-bin.000023 是用来记录4:00之后对数据库的所有“增删改”操作。(时间线2)早9:00上班了,业务的需求会对数据库进行各种“增删改”操作~~~ @ 比如:创建一个学生表并插入、修改了数据等等: CREATE TABLE IF NOT EXISTS `tt` ( `id` int(10) unsigned NOT NULL AUTO_INCREMENT, `name` varchar(16) NOT NULL, `sex` enum('m','w') NOT NULL DEFAULT 'm', `age` tinyint(3) unsigned NOT NULL, `classid` char(6) DEFAULT NULL, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARSET=utf8;导入实验数据 insert into zyyshop.tt(`name`,`sex`,`age`,`classid`) values('yiyi','w',20,'cls1'),('xiaoer','m',22,'cls3'),('zhangsan','w',21,'cls5'),('lisi','m',20,'cls4'),('wangwu','w',26,'cls6');查看数据 mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | xiaoer | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | lisi | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+中午时分又执行了修改数据操作mysql> update zyyshop.tt set name='李四' where id=4;mysql> update zyyshop.tt set name='小二' where id=2;修改后的结果: mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | 小二 | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | 李四 | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+(时间线3)假设此时是下午18:00,莫名地执行了一条悲催的SQL语句,整个数据库都没了: # 删除数据库请勿使用正式环境数据 mysql> drop database zyyshop;七、怎么解决恢复 ?别慌!先仔细查看最后一个binlog日志,并记录下关键的pos点,到底是哪个pos点的操作导致了数据库的破坏(通常在最后几步);备份一下最后一个binlog日志文件: ll /usr/local/mysql/data | grep mysql-bin cp -v /usr/local/mysql/data/mysql-bin.000023 /root/此时执行一次刷新日志索引操作,重新开始新的binlog日志记录文件,理论说 mysql-bin.000023 这个文件不会再有后续写入了(便于我们分析原因及查找pos点),以后所有数据库操作都会写入到下一个日志文件; mysql> flush logs; mysql> show master status;2 .读取binlog日志,分析问题方式一:使用mysqlbinlog读取binlog日志:mysqlbinlog /usr/local/mysql/data/mysql-bin.000023方式二:登录服务器,并查看(推荐): mysql> show binlog events in 'mysql-bin.000023'; 以下为末尾片段: +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ | Log_name | Pos | Event_type | Server_id | End_log_pos | Info | +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ | mysql-bin.000023 | 922 | Xid | 1 | 953 | COMMIT /* xid=3820 */ | | mysql-bin.000023 | 953 | Query | 1 | 1038 | BEGIN | | mysql-bin.000023 | 1038 | Query | 1 | 1164 | use `zyyshop`; update zyyshop.tt set name='李四' where id=4| | mysql-bin.000023 | 1164 | Xid | 1 | 1195 | COMMIT /* xid=3822 */ | | mysql-bin.000023 | 1195 | Query | 1 | 1280 | BEGIN | | mysql-bin.000023 | 1280 | Query | 1 | 1406 | use `zyyshop`; update zyyshop.tt set name='小二' where id=2| | mysql-bin.000023 | 1406 | Xid | 1 | 1437 | COMMIT /* xid=3823 */ | | mysql-bin.000023 | 1437 | Query | 1 | 1538 | drop database zyyshop | +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ 通过分析,造成数据库破坏的pos点区间是介于 1437--1538 之间,只要恢复到1437前就可。3.现在把凌晨备份的数据恢复:mysql -uroot -p123456 -v < /root/BAK.zyyshop.sql;注: 至此截至当日凌晨(4:00)前的备份数据都恢复了。但今天一整天(4:00--18:00)的数据肿么办呢?就得从前文提到的 mysql-bin.000023 新日志做文章了......4 .从binlog日志恢复数据恢复语法格式:mysqlbinlog mysql-bin.0000xx | mysql -u用户名 -p密码 数据库名 常用选项: --start-position=953 起始pos点 --stop-position=1437 结束pos点 --start-datetime="2013-11-29 13:18:54" 起始时间点 --stop-datetime="2013-11-29 13:21:53" 结束时间点 --database=zyyshop 指定只恢复zyyshop数据库(一台主机上往往有多个数据库,只限本地log日志) 不常用选项: -u --user=name Connect to the remote server as username.连接到远程主机的用户名 -p --password[=name] Password to connect to remote server.连接到远程主机的密码 -h --host=name Get the binlog from server.从远程主机上获取binlog日志 --read-from-remote-server Read binary logs from a MySQL server.从某个MySQL服务器上读取binlog日志小结:实际是将读出的binlog日志内容,通过管道符传递给mysql命令。这些命令、文件尽量写成绝对路径;A.完全恢复(本例不靠谱,因为最后那条 drop database zyyshop 也在日志里,必须想办法把这条破坏语句排除掉,做部分恢复)/mysqlbinlog /usr/local/mysql/data/mysql-bin.000021 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop `` B.指定pos结束点恢复(部分恢复): @ --stop-position=953 pos结束点 注:此pos结束点介于“导入实验数据”与更新“name='李四'”之间,这样可以恢复到更改“name='李四'”之前的“导入测试数据” # /usr/local/mysql/bin/mysqlbinlog --stop-position=953 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop 在另一终端登录查看结果(成功恢复了): mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | xiaoer | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | lisi | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+``C.指定pso点区间恢复(部分恢复):更新 name='李四' 这条数据,日志区间是Pos[1038] --> End_log_pos[1164],按事务区间是:Pos[953] --> End_log_pos[1195];更新 name='小二' 这条数据,日志区间是Pos[1280] --> End_log_pos[1406],按事务区间是:Pos[1195] --> End_log_pos[1437];c1.单独恢复 name='李四' 这步操作,可这样:mysqlbinlog --start-position=1038 --stop-position=1164 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop也可以按事务区间单独恢复,如下:mysqlbinlog --start-position=953 --stop-position=1195 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopc2.单独恢复 name='小二' 这步操作,可这样:mysqlbinlog --start-position=1280 --stop-position=1406 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop也可以按事务区间单独恢复,如下:mysqlbinlog --start-position=1195 --stop-position=1437 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopc3.将 name='李四'、name='小二' 多步操作一起恢复,需要按事务区间,可这样:mysqlbinlog --start-position=953 --stop-position=1437 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopD.在另一终端登录查看目前结果(两名称也恢复了): mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | 小二 | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | 李四 | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+E.也可指定时间区间恢复(部分恢复):除了用pos点的办法进行恢复,也可以通过指定时间区间进行恢复,按时间恢复需要用mysqlbinlog命令读取binlog日志内容,找时间节点。比如,我把刚恢复的tt表删除掉,再用时间区间点恢复 mysql> drop table tt; @ --start-datetime="2013-11-29 13:18:54" 起始时间点 @ --stop-datetime="2013-11-29 13:21:53" 结束时间点执行命令 mysqlbinlog --start-datetime="2013-11-29 13:18:54" --stop-datetime="2013-11-29 13:21:53" --database=zyyshop /usr/local/mysql/data/mysql-bin.000021 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop总结:所谓恢复的原理 ,就是让mysql将保存在binlog日志中指定段落区间的sql语句逐个重新执行一次而已。

Mysql数据库误删/错删数据恢复-binlog日志使用 一、binlog 基本认识MySQL的二进制日志可以说是MySQL最重要的日志了,它记录了所有的DDL和DML(除了数据查询语句)语句,以事件形式记录,还包含语句所执行的消耗的时间,MySQL的二进制日志是事务安全型的。一般来说开启二进制日志大概会有1%的性能损耗(参见MySQL官方中文手册 5.1.24版)。二进制有两个最重要的使用场景:MySQL Replication在Master端开启binlog,Mster把它的二进制日志传递给slaves来达到master-slave数据一致的目的,也就是大家比较常听到主从复制,和读写分离的应用场景数据恢复,通过使用mysqlbinlog工具来使恢复数据,也是大家说的数据恢复,用于数据误删找回的场景使用。二进制日志包括两类文件:二进制日志索引文件(文件名后缀为.index)用于记录所有的二进制文件,二进制日志文件(文件名后缀为.00000*)记录数据库所有的DDL和DML(除了数据查询语句)语句事件。二、开启binlog日志编辑打开mysql配置文件vi /usr/local/mysql/etc/my.cnf在[mysqld] 区块下,设置/添加 log-bin=mysql-bin 确认是打开状态(值 mysql-bin 是日志的基本名或前缀名); #开启log日志 log-bin = mysql-bin #默认路径可修改 log_bin = /var/lib/mysql/mysql-bin.log #日志过期时间,设置为0则永不过期,默认设置不过期 expire_logs_days = 7 #模式 binlog_format = ROW #超过max_binlog_size或超过6小时会切换到下一序号文件 max_binlog_size = 100M #二进制日志缓冲大小,通过show status like 'binlog_%';查看调整写入磁盘的次数,写入磁盘为0最好 binlog_cache_size = 16M max_binlog_cache_size = 256M #改参数默认是打开的,在数据库启动后立即启动自动relay log恢复,在恢复过程中,创建一个新的relay log文件,将sql线程的位置初始化到新的relay log,并将i/o线程初始化到sql线程位置。 relay_log_recovery = 1 关于MYSQL中binlog_format参数说明重启mysqld服务使配置生效三、登录mysql服务器,通过mysql的变量配置表,查看二进制日志是否已开启登录服务器mysql -uroot -p123456 mysql> show variables like 'log_%'; +----------------------------------------+---------------------------------------+ | Variable_name | Value | +----------------------------------------+---------------------------------------+ | log_bin | ON | ------> ON表示已经开启binlog日志 | log_bin_basename | /usr/local/mysql/data/mysql-bin | | log_bin_index | /usr/local/mysql/data/mysql-bin.index | | log_bin_trust_function_creators | OFF | | log_bin_use_v1_row_events | OFF | | log_error | /usr/local/mysql/data/martin.err | | log_output | FILE | | log_queries_not_using_indexes | OFF | | log_slave_updates | OFF | | log_slow_admin_statements | OFF | | log_slow_slave_statements | OFF | | log_throttle_queries_not_using_indexes | 0 | | log_warnings | 1 | +----------------------------------------+---------------------------------------+四、常用binlog日志操作命令1.查看所有binlog日志列表 mysql> show master logs;2.查看master状态,即最后(最新)一个binlog日志的编号名称,及其最后一个操作事件pos结束点(Position)值 mysql> show master status;3.刷新log日志,自此刻开始产生一个新编号的binlog日志文件 mysql> flush logs; 注: 每当mysqld服务重启时,会自动执行此命令,刷新binlog日志;在mysqldump备份数据时加 -F 选项也会刷新binlog日志;4.重置(清空)所有binlog日志,请勿在正式环境操作mysql> reset master;五、查看某个binlog日志内容,常用有两种方式:1.使用mysqlbinlog自带查看命令法:注: binlog是二进制文件,普通文件查看器cat more vi等都无法打开,必须使用自带的 mysqlbinlog 命令查看binlog日志与数据库文件在同目录中(我的环境配置安装是选择在/usr/local/mysql/data中)使用mysqlbinlog命令时如果报错,就加上 --no-defaults选项mysqlbinlog /usr/local/mysql/data/mysql-bin.000013下面截取一个片段分析: # at 552 #131128 17:50:46 server id 1 end_log_pos 665 Query thread_id=11 exec_time=0 error_code=0 ---->执行时间:17:50:46;pos点:665 SET TIMESTAMP=1385632246/*!*/; update zyyshop.stu set name='李四' where id=4 ---->执行的SQL /*!*/; # at 665 #131128 17:50:46 server id 1 end_log_pos 692 Xid = 1454 ---->执行时间:17:50:46;pos点:692 注:server id 1 数据库主机的服务号;end_log_pos 665 pos点thread_id=11 线程号2.上面这种办法读取出binlog日志的全文内容较多,不容易分辨查看pos点信息,这里介绍一种更为方便的查询命令: show binlog events [IN 'log_name'] [FROM pos] [LIMIT [offset,] row_count]; 选项解析:IN 'log_name' 指定要查询的binlog文件名(不指定就是第一个binlog文件)FROM pos 指定从哪个pos起始点开始查起(不指定就是从整个文件首个pos点开始算)LIMIT [offset,] 偏移量(不指定就是0)row_count 查询总条数(不指定就是所有行) 截取部分查询结果: *************************** 20. row *************************** Log_name: mysql-bin.000021 ----------------------------------------------> 查询的binlog日志文件名 Pos: 11197 ----------------------------------------------------------> pos起始点: Event_type: Query ----------------------------------------------------------> 事件类型:Query Server_id: 1 --------------------------------------------------------------> 标识是由哪台服务器执行的 End_log_pos: 11308 ----------------------------------------------------------> pos结束点:11308(即:下行的pos起始点) Info: use `zyyshop`; INSERT INTO `team2` VALUES (0,345,'asdf8er5') ---> 执行的sql语句 *************************** 21. row *************************** Log_name: mysql-bin.000021 Pos: 11308 ----------------------------------------------------------> pos起始点:11308(即:上行的pos结束点) Event_type: Query Server_id: 1 End_log_pos: 11417 Info: use `zyyshop`; /*!40000 ALTER TABLE `team2` ENABLE KEYS */ *************************** 22. row *************************** Log_name: mysql-bin.000021 Pos: 11417 Event_type: Query Server_id: 1 End_log_pos: 11510 Info: use `zyyshop`; DROP TABLE IF EXISTS `type`这条语句可以将指定的binlog日志文件,分成有效事件行的方式返回,并可使用limit指定pos点的起始偏移,查询条数;A.查询第一个(最早)的binlog日志: mysql> show binlog events\G; B.指定查询 mysql-bin.000021 这个文件:mysql> show binlog events in 'mysql-bin.000021';C.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起:mysql> show binlog events in 'mysql-bin.000021' from 8224;D.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起,查询10条mysql> show binlog events in 'mysql-bin.000021' from 8224 limit 10;E.指定查询 mysql-bin.000021 这个文件,从pos点:8224开始查起,偏移2行,查询10条 mysql> show binlog events in 'mysql-bin.000021' from 8224 limit 2,10;六、binlog日志恢复实验我们来模拟数据恢复的场景 ,zyyshop是数据库1.(时间线1)假设现在是凌晨4:00,我的计划任务开始执行一次完整的数据库备份:将zyyshop数据库备份到 /root/BAK.zyyshop.sql 文件中:mysqldump -uroot -p123456 -lF --log-error=/root/myDump.err -B zyyshop > /root/BAK.zyyshop.sql大约过了若干分钟,备份完成了,我不用担心数据丢失了,因为我们有备份了由于我使用了-F选项,当备份工作刚开始时系统会刷新log日志,产生新的binlog日志来记录备份之后的数据库“增删改”操作,查看一下: mysql> show master status; +------------------+----------+--------------+------------------+ | File | Position | Binlog_Do_DB | Binlog_Ignore_DB | +------------------+----------+--------------+------------------+ | mysql-bin.000023 | 120 | | | +------------------+----------+--------------+------------------+也就是说, mysql-bin.000023 是用来记录4:00之后对数据库的所有“增删改”操作。(时间线2)早9:00上班了,业务的需求会对数据库进行各种“增删改”操作~~~ @ 比如:创建一个学生表并插入、修改了数据等等: CREATE TABLE IF NOT EXISTS `tt` ( `id` int(10) unsigned NOT NULL AUTO_INCREMENT, `name` varchar(16) NOT NULL, `sex` enum('m','w') NOT NULL DEFAULT 'm', `age` tinyint(3) unsigned NOT NULL, `classid` char(6) DEFAULT NULL, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARSET=utf8;导入实验数据 insert into zyyshop.tt(`name`,`sex`,`age`,`classid`) values('yiyi','w',20,'cls1'),('xiaoer','m',22,'cls3'),('zhangsan','w',21,'cls5'),('lisi','m',20,'cls4'),('wangwu','w',26,'cls6');查看数据 mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | xiaoer | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | lisi | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+中午时分又执行了修改数据操作mysql> update zyyshop.tt set name='李四' where id=4;mysql> update zyyshop.tt set name='小二' where id=2;修改后的结果: mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | 小二 | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | 李四 | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+(时间线3)假设此时是下午18:00,莫名地执行了一条悲催的SQL语句,整个数据库都没了: # 删除数据库请勿使用正式环境数据 mysql> drop database zyyshop;七、怎么解决恢复 ?别慌!先仔细查看最后一个binlog日志,并记录下关键的pos点,到底是哪个pos点的操作导致了数据库的破坏(通常在最后几步);备份一下最后一个binlog日志文件: ll /usr/local/mysql/data | grep mysql-bin cp -v /usr/local/mysql/data/mysql-bin.000023 /root/此时执行一次刷新日志索引操作,重新开始新的binlog日志记录文件,理论说 mysql-bin.000023 这个文件不会再有后续写入了(便于我们分析原因及查找pos点),以后所有数据库操作都会写入到下一个日志文件; mysql> flush logs; mysql> show master status;2 .读取binlog日志,分析问题方式一:使用mysqlbinlog读取binlog日志:mysqlbinlog /usr/local/mysql/data/mysql-bin.000023方式二:登录服务器,并查看(推荐): mysql> show binlog events in 'mysql-bin.000023'; 以下为末尾片段: +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ | Log_name | Pos | Event_type | Server_id | End_log_pos | Info | +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ | mysql-bin.000023 | 922 | Xid | 1 | 953 | COMMIT /* xid=3820 */ | | mysql-bin.000023 | 953 | Query | 1 | 1038 | BEGIN | | mysql-bin.000023 | 1038 | Query | 1 | 1164 | use `zyyshop`; update zyyshop.tt set name='李四' where id=4| | mysql-bin.000023 | 1164 | Xid | 1 | 1195 | COMMIT /* xid=3822 */ | | mysql-bin.000023 | 1195 | Query | 1 | 1280 | BEGIN | | mysql-bin.000023 | 1280 | Query | 1 | 1406 | use `zyyshop`; update zyyshop.tt set name='小二' where id=2| | mysql-bin.000023 | 1406 | Xid | 1 | 1437 | COMMIT /* xid=3823 */ | | mysql-bin.000023 | 1437 | Query | 1 | 1538 | drop database zyyshop | +------------------+------+------------+-----------+-------------+------------------------------------------------------------+ 通过分析,造成数据库破坏的pos点区间是介于 1437--1538 之间,只要恢复到1437前就可。3.现在把凌晨备份的数据恢复:mysql -uroot -p123456 -v < /root/BAK.zyyshop.sql;注: 至此截至当日凌晨(4:00)前的备份数据都恢复了。但今天一整天(4:00--18:00)的数据肿么办呢?就得从前文提到的 mysql-bin.000023 新日志做文章了......4 .从binlog日志恢复数据恢复语法格式:mysqlbinlog mysql-bin.0000xx | mysql -u用户名 -p密码 数据库名 常用选项: --start-position=953 起始pos点 --stop-position=1437 结束pos点 --start-datetime="2013-11-29 13:18:54" 起始时间点 --stop-datetime="2013-11-29 13:21:53" 结束时间点 --database=zyyshop 指定只恢复zyyshop数据库(一台主机上往往有多个数据库,只限本地log日志) 不常用选项: -u --user=name Connect to the remote server as username.连接到远程主机的用户名 -p --password[=name] Password to connect to remote server.连接到远程主机的密码 -h --host=name Get the binlog from server.从远程主机上获取binlog日志 --read-from-remote-server Read binary logs from a MySQL server.从某个MySQL服务器上读取binlog日志小结:实际是将读出的binlog日志内容,通过管道符传递给mysql命令。这些命令、文件尽量写成绝对路径;A.完全恢复(本例不靠谱,因为最后那条 drop database zyyshop 也在日志里,必须想办法把这条破坏语句排除掉,做部分恢复)/mysqlbinlog /usr/local/mysql/data/mysql-bin.000021 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop `` B.指定pos结束点恢复(部分恢复): @ --stop-position=953 pos结束点 注:此pos结束点介于“导入实验数据”与更新“name='李四'”之间,这样可以恢复到更改“name='李四'”之前的“导入测试数据” # /usr/local/mysql/bin/mysqlbinlog --stop-position=953 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop 在另一终端登录查看结果(成功恢复了): mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | xiaoer | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | lisi | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+``C.指定pso点区间恢复(部分恢复):更新 name='李四' 这条数据,日志区间是Pos[1038] --> End_log_pos[1164],按事务区间是:Pos[953] --> End_log_pos[1195];更新 name='小二' 这条数据,日志区间是Pos[1280] --> End_log_pos[1406],按事务区间是:Pos[1195] --> End_log_pos[1437];c1.单独恢复 name='李四' 这步操作,可这样:mysqlbinlog --start-position=1038 --stop-position=1164 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop也可以按事务区间单独恢复,如下:mysqlbinlog --start-position=953 --stop-position=1195 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopc2.单独恢复 name='小二' 这步操作,可这样:mysqlbinlog --start-position=1280 --stop-position=1406 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop也可以按事务区间单独恢复,如下:mysqlbinlog --start-position=1195 --stop-position=1437 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopc3.将 name='李四'、name='小二' 多步操作一起恢复,需要按事务区间,可这样:mysqlbinlog --start-position=953 --stop-position=1437 --database=zyyshop /usr/local/mysql/data/mysql-bin.000023 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshopD.在另一终端登录查看目前结果(两名称也恢复了): mysql> select * from zyyshop.tt; +----+----------+-----+-----+---------+ | id | name | sex | age | classid | +----+----------+-----+-----+---------+ | 1 | yiyi | w | 20 | cls1 | | 2 | 小二 | m | 22 | cls3 | | 3 | zhangsan | w | 21 | cls5 | | 4 | 李四 | m | 20 | cls4 | | 5 | wangwu | w | 26 | cls6 | +----+----------+-----+-----+---------+E.也可指定时间区间恢复(部分恢复):除了用pos点的办法进行恢复,也可以通过指定时间区间进行恢复,按时间恢复需要用mysqlbinlog命令读取binlog日志内容,找时间节点。比如,我把刚恢复的tt表删除掉,再用时间区间点恢复 mysql> drop table tt; @ --start-datetime="2013-11-29 13:18:54" 起始时间点 @ --stop-datetime="2013-11-29 13:21:53" 结束时间点执行命令 mysqlbinlog --start-datetime="2013-11-29 13:18:54" --stop-datetime="2013-11-29 13:21:53" --database=zyyshop /usr/local/mysql/data/mysql-bin.000021 | /usr/local/mysql/bin/mysql -uroot -p123456 -v zyyshop总结:所谓恢复的原理 ,就是让mysql将保存在binlog日志中指定段落区间的sql语句逐个重新执行一次而已。 -

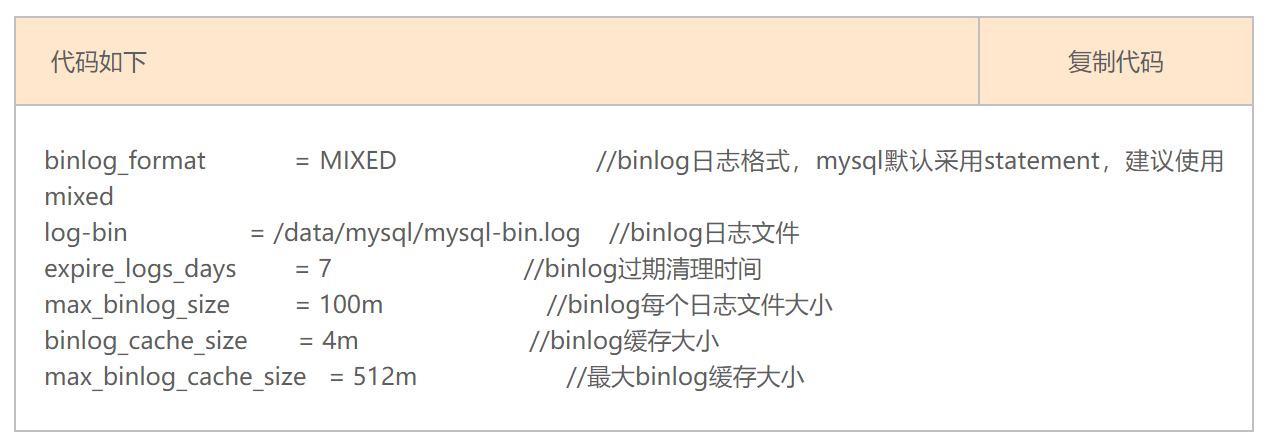

关于MYSQL中BINLOG_FORMAT的三种模式 MYSQL中BINLOG_FORMAT的三种模式mysql复制主要有三种方式:基于SQL语句的复制(statement-based replication, SBR),基于行的复制(row-based replication, RBR),混合模式复制(mixed-based replication, MBR)。对应的,binlog的格式也有三种:STATEMENT,ROW,MIXED。① STATEMENT模式(SBR)每一条会修改数据的sql语句会记录到binlog中。优点是并不需要记录每一条sql语句和每一行的数据变化,减少了binlog日志量,节约IO,提高性能。缺点是在某些情况下会导致master-slave中的数据不一致(如sleep()函数, last_insert_id(),以及user-defined functions(udf)等会出现问题)② ROW模式(RBR)不记录每条sql语句的上下文信息,仅需记录哪条数据被修改了,修改成什么样了。而且不会出现某些特定情况下的存储过程、或function、或trigger的调用和触发无法被正确复制的问题。缺点是会产生大量的日志,尤其是alter table的时候会让日志暴涨。③ MIXED模式(MBR)以上两种模式的混合使用,一般的复制使用STATEMENT模式保存binlog,对于STATEMENT模式无法复制的操作使用ROW模式保存binlog,MySQL会根据执行的SQL语句选择日志保存方式。binlog复制配置在mysql的配置文件my.cnf中,可以通过一下选项配置binglog相关代码如下 复制代码binlog_format = MIXED //binlog日志格式,mysql默认采用statement,建议使用mixedlog-bin = /data/mysql/mysql-bin.log //binlog日志文件expire_logs_days = 7 //binlog过期清理时间max_binlog_size = 100m //binlog每个日志文件大小binlog_cache_size = 4m //binlog缓存大小max_binlog_cache_size = 512m //最大binlog缓存大小三 MIXED说明对于执行的SQL语句中包含now()这样的时间函数,会在日志中产生对应的unix_timestamp()*1000的时间字符串,slave在完成同步时,取用的是sqlEvent发生的时间来保证数据的准确性。另外对于一些功能性函数slave能完成相应的数据同步,而对于上面指定的一些类似于UDF函数,导致Slave无法知晓的情况,则会采用ROW格式存储这些Binlog,以保证产生的Binlog可以供Slave完成数据同步。现在来比较以下 SBR 和 RBR 2中模式各自的优缺点:SBR 的优点:历史悠久,技术成熟binlog文件较小binlog中包含了所有数据库更改信息,可以据此来审核数据库的安全等情况binlog可以用于实时的还原,而不仅仅用于复制主从版本可以不一样,从服务器版本可以比主服务器版本高SBR 的缺点:不是所有的UPDATE语句都能被复制,尤其是包含不确定操作的时候。调用具有不确定因素的 UDF 时复制也可能出问题使用以下函数的语句也无法被复制:LOAD_FILE()UUID()USER()FOUND_ROWS()SYSDATE() (除非启动时启用了 --sysdate-is-now 选项)INSERT ... SELECT 会产生比 RBR 更多的行级锁复制需要进行全表扫描(WHERE 语句中没有使用到索引)的 UPDATE 时,需要比 RBR 请求更多的行级锁对于有 AUTO_INCREMENT 字段的 InnoDB表而言,INSERT 语句会阻塞其他 INSERT 语句对于一些复杂的语句,在从服务器上的耗资源情况会更严重,而 RBR 模式下,只会对那个发生变化的记录产生影响存储函数(不是存储过程)在被调用的同时也会执行一次 NOW() 函数,这个可以说是坏事也可能是好事确定了的 UDF 也需要在从服务器上执行数据表必须几乎和主服务器保持一致才行,否则可能会导致复制出错执行复杂语句如果出错的话,会消耗更多资源RBR 的优点:任何情况都可以被复制,这对复制来说是最安全可靠的和其他大多数数据库系统的复制技术一样多数情况下,从服务器上的表如果有主键的话,复制就会快了很多复制以下几种语句时的行锁更少:INSERT ... SELECT包含 AUTO_INCREMENT 字段的 INSERT没有附带条件或者并没有修改很多记录的 UPDATE 或 DELETE 语句执行 INSERT,UPDATE,DELETE 语句时锁更少从服务器上采用多线程来执行复制成为可能RBR 的缺点:binlog 大了很多复杂的回滚时 binlog 中会包含大量的数据主服务器上执行 UPDATE 语句时,所有发生变化的记录都会写到 binlog 中,而 SBR 只会写一次,这会导致频繁发生 binlog 的并发写问题UDF 产生的大 BLOB 值会导致复制变慢无法从 binlog 中看到都复制了写什么语句当在非事务表上执行一段堆积的SQL语句时,最好采用 SBR 模式,否则很容易导致主从服务器的数据不一致情况发生另外,针对系统库 mysql 里面的表发生变化时的处理规则如下:如果是采用 INSERT,UPDATE,DELETE 直接操作表的情况,则日志格式根据 binlog_format 的设定而记录如果是采用 GRANT,REVOKE,SET PASSWORD 等管理语句来做的话,那么无论如何都采用 SBR 模式记录注:采用 RBR 模式后,能解决很多原先出现的主键重复问题。原文转载:https://www.cnblogs.com/xingyunfashi/p/8431780.html

关于MYSQL中BINLOG_FORMAT的三种模式 MYSQL中BINLOG_FORMAT的三种模式mysql复制主要有三种方式:基于SQL语句的复制(statement-based replication, SBR),基于行的复制(row-based replication, RBR),混合模式复制(mixed-based replication, MBR)。对应的,binlog的格式也有三种:STATEMENT,ROW,MIXED。① STATEMENT模式(SBR)每一条会修改数据的sql语句会记录到binlog中。优点是并不需要记录每一条sql语句和每一行的数据变化,减少了binlog日志量,节约IO,提高性能。缺点是在某些情况下会导致master-slave中的数据不一致(如sleep()函数, last_insert_id(),以及user-defined functions(udf)等会出现问题)② ROW模式(RBR)不记录每条sql语句的上下文信息,仅需记录哪条数据被修改了,修改成什么样了。而且不会出现某些特定情况下的存储过程、或function、或trigger的调用和触发无法被正确复制的问题。缺点是会产生大量的日志,尤其是alter table的时候会让日志暴涨。③ MIXED模式(MBR)以上两种模式的混合使用,一般的复制使用STATEMENT模式保存binlog,对于STATEMENT模式无法复制的操作使用ROW模式保存binlog,MySQL会根据执行的SQL语句选择日志保存方式。binlog复制配置在mysql的配置文件my.cnf中,可以通过一下选项配置binglog相关代码如下 复制代码binlog_format = MIXED //binlog日志格式,mysql默认采用statement,建议使用mixedlog-bin = /data/mysql/mysql-bin.log //binlog日志文件expire_logs_days = 7 //binlog过期清理时间max_binlog_size = 100m //binlog每个日志文件大小binlog_cache_size = 4m //binlog缓存大小max_binlog_cache_size = 512m //最大binlog缓存大小三 MIXED说明对于执行的SQL语句中包含now()这样的时间函数,会在日志中产生对应的unix_timestamp()*1000的时间字符串,slave在完成同步时,取用的是sqlEvent发生的时间来保证数据的准确性。另外对于一些功能性函数slave能完成相应的数据同步,而对于上面指定的一些类似于UDF函数,导致Slave无法知晓的情况,则会采用ROW格式存储这些Binlog,以保证产生的Binlog可以供Slave完成数据同步。现在来比较以下 SBR 和 RBR 2中模式各自的优缺点:SBR 的优点:历史悠久,技术成熟binlog文件较小binlog中包含了所有数据库更改信息,可以据此来审核数据库的安全等情况binlog可以用于实时的还原,而不仅仅用于复制主从版本可以不一样,从服务器版本可以比主服务器版本高SBR 的缺点:不是所有的UPDATE语句都能被复制,尤其是包含不确定操作的时候。调用具有不确定因素的 UDF 时复制也可能出问题使用以下函数的语句也无法被复制:LOAD_FILE()UUID()USER()FOUND_ROWS()SYSDATE() (除非启动时启用了 --sysdate-is-now 选项)INSERT ... SELECT 会产生比 RBR 更多的行级锁复制需要进行全表扫描(WHERE 语句中没有使用到索引)的 UPDATE 时,需要比 RBR 请求更多的行级锁对于有 AUTO_INCREMENT 字段的 InnoDB表而言,INSERT 语句会阻塞其他 INSERT 语句对于一些复杂的语句,在从服务器上的耗资源情况会更严重,而 RBR 模式下,只会对那个发生变化的记录产生影响存储函数(不是存储过程)在被调用的同时也会执行一次 NOW() 函数,这个可以说是坏事也可能是好事确定了的 UDF 也需要在从服务器上执行数据表必须几乎和主服务器保持一致才行,否则可能会导致复制出错执行复杂语句如果出错的话,会消耗更多资源RBR 的优点:任何情况都可以被复制,这对复制来说是最安全可靠的和其他大多数数据库系统的复制技术一样多数情况下,从服务器上的表如果有主键的话,复制就会快了很多复制以下几种语句时的行锁更少:INSERT ... SELECT包含 AUTO_INCREMENT 字段的 INSERT没有附带条件或者并没有修改很多记录的 UPDATE 或 DELETE 语句执行 INSERT,UPDATE,DELETE 语句时锁更少从服务器上采用多线程来执行复制成为可能RBR 的缺点:binlog 大了很多复杂的回滚时 binlog 中会包含大量的数据主服务器上执行 UPDATE 语句时,所有发生变化的记录都会写到 binlog 中,而 SBR 只会写一次,这会导致频繁发生 binlog 的并发写问题UDF 产生的大 BLOB 值会导致复制变慢无法从 binlog 中看到都复制了写什么语句当在非事务表上执行一段堆积的SQL语句时,最好采用 SBR 模式,否则很容易导致主从服务器的数据不一致情况发生另外,针对系统库 mysql 里面的表发生变化时的处理规则如下:如果是采用 INSERT,UPDATE,DELETE 直接操作表的情况,则日志格式根据 binlog_format 的设定而记录如果是采用 GRANT,REVOKE,SET PASSWORD 等管理语句来做的话,那么无论如何都采用 SBR 模式记录注:采用 RBR 模式后,能解决很多原先出现的主键重复问题。原文转载:https://www.cnblogs.com/xingyunfashi/p/8431780.html